El día de hoy ha aparecido en la revista Wired, un artículo en el que se anuncia la llegada de una nueva era en lo que toca a la investigación científica, y que se ha dado en llamar la era Petabyte ( 1 Petabyte = 1 PB = 106 GB). Como la revista resume el método científico que hemos usado hasta la fecha para poder comprender el universo se basa en un ciclo de "Hipótesis ⇒ Modelo ⇒ Experimento". Donde primero nos formulamos una hipótesis sobre la cuál desarrollamos un modelo que explique un fenómeno de la naturaleza y luego aplicamos un experimento que nos llevará a probar la veracidad o falcedad del modelo.

Pues bien con la llegada de los grandes clusters de computadoras que pueden lidiar con cantidades de datos, jamas antes imaginadas ahora es posible con un simple modelo estadístico encontrar la respuesta que buscamos a todo problema científico. En pocas palabras con suficientes datos recolectados, los números hablaran por si mismos. Como ejemplifica claramente el artículo, es posible con una cantidad de datos equivalente que Google puede hacer traducciones entre Klingon (lenguaje ficticio, perteneciente al universo ficticio de Star Trek) y Farsi (el idioma que se habla en Irán), sin que el Google entienda una sola palabra de ambos idiomas, así como hace la traducción entre Francés y Alemán.

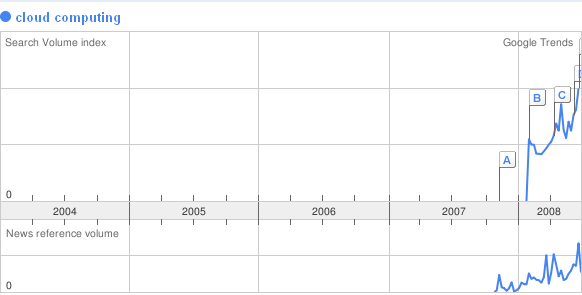

Esta capacidad de usar las matemáticas para encontrar cuál es el mejor anuncio para una página web, sin necesidad de que Google entienda el contenido de dicha página web o el anuncio en sí, ha hecho que Google se apodere del negocio de la publicidad contextual, en pocas palabras con suficiente poder de procesamiento y almacenamiento de datos, un simple algoritmo como el de correlación puede hacer obsoletas disciplinas como la taxonomía, ontología o psicología.

Ya no interesa buscar los mecanismos subyacentes de un hecho, por ejemplo el modelo newtoniano funcionó por doscientos años, hasta que fue reemplazado por el modelo cuántico, y ya hemos encontrada limitaciones al modelo cuántico que nos han llevado a formular modelos de universos de n-dimensiones. Pero aún por más elaborado que sea el modelo este siempre contiene debilidades, y es propenso a errores, sin embargo los datos son reales, los datos son.

En el artículo se pone como un ejemplo exitoso de esta recolección secuancial y sistemática de datos, a la que llama serialización, el caso del investigador Craig Venter, que ha investigado el genoma humano, y luego paso a estudiar con el mismo método el de todos los seres vivos de la tierra, el océano y el aire, llegando a descubrir nuevas especies que no habían sido descubiertas, usando solamente la colección meticulosa y procesamiento de datos.

Teniendo ésto en mente, ahora comprendo por qué todas las super-potencias compiten por tener la computadora más potente, pues sencillamente más poder de cálculo/almacenamiento representa mayor capacidad para comprender los eventos y les otorga una enorme ventaja competitiva. Eso explica también por qué las grandes compañías de bolsa de Wall Street (que poseen grandes clusters también) no se desplomaron con la crisis del sector inmobilirio en agosto del año pasado y fueron capaces de manipular el mercado hasta la fecha.

La era del método científico ha terminado, demosle la bienvenida al método del uso intensivo de los datos, ha llegado la era del Petabyte.